Méthodes de travail avec les données de recherche

10 Soutenir la recherche reproductible avec la curation active de données

Sandra Sawchuk; Louise Gillis; et Lachlan MacLeod

Objectifs d’apprentissage

À la fin de ce chapitre, vous pourrez:

- Comprendre le rôle de la curation active de données dans le domaine plus large de la gestion des données de recherche.

- Identifier les caractéristiques principales des outils de gestion active des données, tels que le versionnage, la rédaction de scripts, les conteneurs informatiques et les machines virtuelles.

- Évaluer un exemple d’un jeu de données reproductible dans un conteneur.

Introduction

Ce chapitre mettra l’accent sur les aspects interopérables et réutilisables du modèle FAIR (facile à trouver, accessible, interopérable et réutilisable) qui ont été présentés dans le chapitre 2, « Les principes FAIR et la gestion des données de recherche. » Ainsi, vous obtiendrez la confiance et les compétences nécessaires pour entreprendre la curation active des données.

La curation active des données appliquée en cours de recherche produit des données qui sont FAIR : faciles à trouver, accessibles, interopérables et réutilisables (Johnston et al., 2017a; Wilkinson et al., 2016). Le terme « active » décrit les pratiques de curation appliquées pendant les étapes de la collecte, de l’analyse et de la diffusion des données d’une recherche. La curation des données implique la gestion des données de recherche sélectionnées ou qui doivent être déposées pour le stockage et la préservation à long terme. (Krier et Strasser, 2014). Règle générale, la curation est abordée vers la fin d’un projet, souvent une fois l’analyse complétée. D’excellentes ressources, telles que le Guide pour la curation dans Dataverse ainsi que le flux de travail CURATED (en anglais uniquement) du Data Curation Network, fournissent de précieux conseils pour la curation lorsque la phase active du projet est terminée (Cooper et al., 2021; Johnston et al., 2017b). Il y a des avantages à travailler sur la curation tout au long du projet. Cela permet de repérer les erreurs avant qu’elles ne deviennent catastrophiques et les données peuvent aussi être mieux décrites et contextualisées (Sawchuk et Khair, 2021).

Ce chapitre vous informera sur les outils et les techniques qui facilitent la curation des données de recherche tout au long des phases actives d’une recherche. Comme Cooper et al. (2021), nous savons que la capacité d’appui à la curation peut varier d’un établissement canadien à l’autre et que les bibliothèques ont souvent le rôle d’éduquer et de sensibiliser sur les meilleures pratiques. Quant à la gestion concrète et quotidienne de la recherche et des données associées au projet, elle tombe sous la responsabilité des chercheuses et chercheurs qui effectuent le travail.

Nous discuterons des stratégies pour la mise en place de bonnes pratiques de gestion des données en misant sur les activités qui contribuent à l’amélioration de l’interopérabilité et de la reproductibilité des données. Nous examinerons également les meilleures pratiques en matière de curation des données de recherche, y compris les outils pour la communication et la collaboration. Même si les outils présentés dans ce chapitre sont généralement utilisés pour appuyer la recherche computationnelle, les principes de reproductibilité que nous présenterons pourront servir à toutes les disciplines.

Les plateformes

Le choix d’une plateforme de stockage des données n’est pas considéré comme de la curation. Toutefois, le choix d’une plateforme de stockage plutôt qu’une autre peut avoir des conséquences importantes sur la curation.

Les options de stockage sont abordées plus en détail dans le chapitre 5, « Partage et réutilisation des données de recherche au Canada, » mais voici un survol rapide. Votre choix de plateforme s’inscrit dans l’une ou l’autre des trois catégories suivantes :

- Le stockage local est intégré ou se connecte directement à vos appareils. Cela inclut les disques durs et les clés USB;

- Les unités de stockage en réseau (NAS ou Network Attached Storage) relient les appareils d’un même réseau local. Des exemples comprennent les serveurs départementaux, de facultés ou universitaires;

- Le stockage infonuagique est un service en ligne fourni par une tierce partie. Des exemples comprennent Dropbox, Google Drive, OSF et OneDrive.

Le tableau 1 énumère les avantages et désavantages de chacun de ces types de plateformes. Chacun a son utilité propre, mais somme toute, l’infonuagique semble offrir des fonctionnalités bien adaptées à la curation.

| Avantages | Désavantages | |

|

Local |

|

|

|

Réseau |

|

|

|

Infonuagique |

|

|

Les données personnelles de santé sont assujetties à des législations qui empêchent leur stockage à l’extérieur du Canada. Les données personnelles pouvant identifier des personnes participantes ne doivent pas être stockées sur des plateformes infonuagiques dont la prise en charge n’est pas institutionnelle.

Lignes directrices pour le stockage des données

- Lorsque possible, privilégiez l’utilisation d’une plateforme infonuagique et faites la sauvegarde de vos données sur un réseau institutionnel. La plupart des plateformes infonuagiques comportent des fonctionnalités qui gèrent le versionnage de façon automatique. L’automatisation implique moins de travail pour vous et moins de risques d’erreurs humaines. Les fichiers importants peuvent être copiés sur le réseau de l’établissement, régulièrement sauvegardé, protégeant davantage contre la perte de données qui pourrait survenir sur des disques locaux.

À chaque fois que vous faites une modification dans un environnement infonuagique, une nouvelle version de votre fichier est sauvegardée avec l’information sur la provenance du fichier:

- qui a fait la modification;

- quand la modification a été faite;

- qu’est-ce qui a été modifié.

- Choisissez une solution soutenue par votre établissement. Vous aurez ainsi accès au soutien technique, à la formation et à l’assurance qu’elle a été évaluée. Le choix d’une solution bien supportée permet d’augmenter les probabilités que vos données soient accessibles et utilisables à long terme. Au Canada, Microsoft Office 365 peut s’avérer un bon choix puisque de nombreuses universités utilisent cette suite de logiciels.

- Utilisez un cahier de laboratoire électronique ou un outil de gestion de projet. Les cahiers de laboratoire électroniques sont des outils en ligne conçus selon le design et l’utilisation de leurs équivalents papier. Dans leur forme la plus simple, ils fournissent un espace où consigner les protocoles de recherches, les observations, les notes et d’autres données reliées au projet. Leur format électronique permet une bonne gestion des données évitant des problématiques telles qu’une écriture manuscrite difficile à déchiffrer et des pertes de données liées à des dommages matériels. Les cahiers de laboratoire électroniques assurent également la sécurité des données et permettent la collaboration. Ils peuvent être particulièrement utiles si vous travaillez dans le secteur privé ou dans des contextes où les membres de l’équipe de recherche proviennent de différents établissements. Au-delà des solutions institutionnelles, vous pouvez vous tourner vers des outils de collaboration comme Open Science Framework (OSF), une application en code source libre dont l’utilisation est gratuite et qui fournit des détails sur la provenance des fichiers. OSF peut être utilisé en tant qu’espace collaboratif de partage des données, ou en tant que cahier de laboratoire électronique.

La sécurité des données

Identifiez les risques potentiels dans votre plan de gestion des données de recherche (GDR) et assurez-vous que la mise en œuvre des mesures élaborées est réalisable et répond bien au risque associé à vos données. Si vous travaillez avec des données personnelles de santé par exemple, vous devez faire davantage attention que si vous travaillez avec du code source libre. Des considérations similaires doivent être gardées à l’esprit si vous travaillez avec des données issues de groupes marginalisés ou racisés. Votre choix de plateforme de stockage est également important. Les données stockées sur des clés USB peuvent être perdues ou endommagées, tandis que celles sur un stockage infonuagique peuvent être la proie de piratage, de logiciels malveillants et d’hameçonnage.

Lignes directrices dans le traitement de la sécurité des données

- Évitez l’utilisation de disques externes ou de stockage local.

- Sécurisez votre ordinateur et vos réseaux en installant les mises à jour logicielles et les protections antivirus, en activant les pare-feux et en verrouillant votre ordinateur et autres appareils quand vous ne les utilisez pas.

- Utilisez des mots de passe robustes. Les mots de passe robustes sont uniques et complexes (de longues chaînes de caractères qui utilisent une combinaison de symboles, de chiffres et de lettres majuscules et minuscules). Malheureusement, ils sont aussi difficiles à mémoriser. Une solution est d’utiliser un gestionnaire de mots de passe, tel que KeePassX ou 1Password, qui enregistre vos noms d’utilisateurs et mots de passe dans un même endroit. Modifiez régulièrement vos mots de passe!

- Chiffrez vos fichiers et disques si vous travaillez avec des données sensibles ou propriétaires. Avec des ordinateurs Mac, vous pouvez utiliser Firevault et avec des PC, Bitlocker.

- Si vous travaillez sur une plateforme infonuagique, utilisez l’authentification multifactorielle pour accéder aux fichiers.

- Lorsque vous transférez des données, utilisez le chiffrement. OneDrive est un exemple de plateforme de stockage qui permet l’envoi et la réception de fichiers chiffrés. Le transfert de fichiers par Globus est une bonne option pour des fichiers lourds et de nombreux établissements de recherche utilisent Globus pour les données de recherche sensibles.

La curation active des données

La curation active des données implique l’organisation, la description ainsi que la gestion de vos fichiers de recherche et de leur documentation. La façon dont vous organisez vos fichiers est un choix personnel. Il n’y a pas une seule et unique façon de faire et la meilleure façon de travailler sera celle qui conviendra le mieux à vous et à votre équipe. Mettez vos décisions par écrit, communiquez-les à toutes les personnes concernées et réévaluez régulièrement vos choix. Si une stratégie ne s’avère plus efficace, modifiez-la et passez à autre chose.

Vous n’avez pas à développer de toutes pièces votre structure organisationnelle ! Des ressources telles que le protocole TIER (en anglais uniquement) peuvent servir comme bon point de départ.

Lignes directrices pour la curation active des données

1. L’organisation des fichiers de recherche

- Identifiez une personne qui prendra en charge l’organisation et le nommage des fichiers. Cette personne peut mener des vérifications ponctuelles pour s’assurer que la documentation, le nommage et les chemins d’accès aux fichiers sont uniformément établis. Elle peut aussi servir de contact principal pour tous les membres de l’équipe de recherche qui auraient des questions sur les pratiques organisationnelles ou voudraient signaler des erreurs dans les données.

- Gardez votre plan organisationnel, la structure et les conventions de nommage des fichiers dans un seul document que vous pourrez imprimer et conserver près de votre ordinateur de travail ou dans un fichier de documentation avec votre projet. Si les documents restent à la portée, ils seront plus facilement consultés que s’ils sont difficiles à trouver.

- Mettez en place des processus de travail clairs pour vous assurer que le travail ne soit pas modifié ou détruit. « Protégez vos données originales en verrouillant vos fichiers (avec un mot de passe) ou en définissant un accès en lecture seule » (Groupe d’experts sur la formation, 2020) pour ensuite les compresser. Créez des espaces de travail distincts pour les différentes équipes de travail avec une personne centrale qui sera responsable de la coordination et de regrouper les différents éléments. Autre option : quand le projet et le calendrier le permettent, faites travailler les équipes selon un horaire régulier, sans chevauchement. Utilisez un diagramme de Gantt ou un modèle semblable pour établir un calendrier de projet et gérer les tâches.

- Organisez avec simplicité. Limitez la quantité de dossiers utilisés. Ainsi, vous trouverez vos données plus facilement et réduirez le temps de traitement pour les sauvegardes et la fusion ou l’analyse d’importants jeux de données.

Saviez-vous que? Les dates dans le format ISO 8601 sont lisibles par machine et peuvent être triées de façon chronologique.

2. La description des fichiers

- Utilisez une convention de nommage qui s’applique à tous les fichiers et créez un document qui explique cette convention. Vous pourrez ainsi prévenir les erreurs et réduire le temps de formation des membres de l’équipe de recherche. Le document servira aussi de base à votre dictionnaire de données (décrit ci-dessous). Il est utile d’y inclure les abréviations ou acronymes des noms de projets, les organismes subventionnaires, les numéros des subventions, le type de contenu, etc. Ajoutez-y des dates (nous recommandons le format AAAA-MM-JJ) et de brèves descriptions. Comme séparateur, utilisez la notation chameau (NotationChameau) ou le trait de soulignement (trait_de_soulignement). Les systèmes informatiques ne reconnaissent pas toujours les espaces et caractères spéciaux.

- Le versionnage devrait être clair et effectué de façon judicieuse. Il n’est pas nécessaire de créer de nouvelles versions pour chaque modification; la mise à jour des numéros de version ne s’impose que lorsque d’importants changements sont apportés au fichier. Utilisez V01, 02, etc. pour rendre l’historique des versions clair et facile à suivre, ou utilisez un système automatisé de contrôle des versions.

- Les fichiers de syntaxe sont des fichiers de code qui contiennent les séquences d’actions effectuées par le logiciel d’analyse statistique; ils peuvent être générés par le logiciel ou codés par les analystes. Effectuez ou enregistrez toutes vos actions en utilisant un fichier de syntaxe qui fait la liste des actions prises par le logiciel d’analyse statistique. Selon le logiciel utilisé, les fichiers de syntaxe peuvent aussi s’appeler des fichiers de programme, des fichiers script ou une autre désignation semblable. La plupart des éditeurs de syntaxe possèdent une fonctionnalité intégrée de notation (ou de commentaire) qui vous aide à vous rappeler ce que vous avez fait et à communiquer ce procédé à vos partenaires de recherche. Ajoutez des descriptions de ce que vous avez fait dans les fichiers de syntaxe et nettoyez la syntaxe au fur et à mesure. Le procédé peut aussi être utile si votre code est utilisé pour de futurs projets ou s’il est publié dans un dépôt de données de recherche.

- Si vous utilisez des logiciels spécialisés pour l’exploration et l’analyse des données, déterminez si la documentation sur le traitement des fichiers de données est générée de façon automatique et complétez-la au besoin. Inscrivez tous les détails dont vous aurez besoin pour reproduire votre flux de travail. Si vous prévoyez de revoir vos données ultérieurement, vous serez reconnaissant de l’effort que vous y aurez mis!

Créez votre propre convention de nommage des fichiers. La feuille de travail (en anglais uniquement) de Krista Briney pour l’établissement de conventions de nommage des fichiers vous guidera tout au long du processus de création d’un plan concret.

3. La création de guides de codification et de dictionnaires de données

Un guide de codification est un document qui fait la description d’un jeu de données, y compris les détails sur son contenu et sa conception. Un dictionnaire de données est un document semblable au guide de codification, lisible et souvent exploitable par une machine, qui contient généralement des informations détaillées sur la structure technique d’un jeu de données en plus de ses contenus (Buchanan et al., 2021). Toutefois, les deux termes sont souvent utilisés de façon interchangeable. Le guide de codification peut être généré de façon automatique par le logiciel de statistiques que vous utilisez ou vous pouvez avoir à le créer vous-même. Développer le guide de codification au fur et à mesure est une bonne pratique qui permet de standardiser les données. Documentez toute modification au code ou toute autre modification aux données. Même si le guide de codification est généré par le logiciel, vous devrez probablement y ajouter des informations supplémentaires. Idéalement, votre guide de codification sera simple, inclura le nom des variables et de brèves descriptions. Toutefois, selon le Inter-university Consortium for Political and Social Research (ICPSR, 2023), les informations contenues dans les guides de codification peuvent varier d’un projet à l’autre et d’un domaine à l’autre.

Vous devriez inclure un guide de codification dans la section méthodologique de l’étude. Comme point de départ, documentez toute analyse effectuée sous forme de notation dans le fichier syntaxe. Un fichier syntaxe bien annoté peut devenir la base de votre guide de codification ou même de la section méthodes d’un rapport, d’une thèse ou d’une publication. Les descriptions méthodologiques varieront considérablement d’un domaine d’étude à l’autre, mais certains éléments clés peuvent toujours être inclus :

- Valeurs et étiquettes de tous les champs

- Inclure une description de la façon dont les valeurs nulles ont été traitées au cours de l’analyse;

- Descriptions ou distributions sommaires des résultats;

- Variables omises ou éliminées;

- Rapport entre les variables, y compris le chaînage (quand du texte est inséré de façon automatique par le logiciel de sondage selon les réponses précédentes) ou des expériences subséquentes.

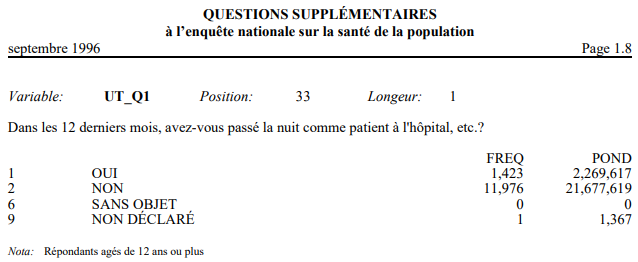

La figure 1 montre l’extrait d’un guide de codification publié par Statistiques Canada pour l’Enquête nationale sur la santé de la population. Dans cet exemple, le guide de codification contient le nom de la variable, la question du sondage et ses réponses ainsi qu’une note sur l’âge des répondants. Ce guide de codification contient aussi la position et la longueur de la variable; cette information serait également incluse dans le dictionnaire des données.

Pour aller plus loin

Peu importe le logiciel que vous choisissez d’utiliser, une documentation complète constitue la clé d’une gestion et d’une curation efficaces des données. Cette section présentera des concepts importants dont il faut tenir compte pour la curation active de la recherche computationnelle, y compris le versionnage des fichiers, la rédaction de scripts et les conteneurs informatiques.

Nous pouvons appliquer les leçons de la curation active des données à la recherche computationnelle. Les ordinateurs sont devenus tellement plus simples et conviviaux à utiliser qu’il est facile d’oublier leur complexité. Les chercheuses et chercheurs ont le choix d’une variété de logiciels libres ou propriétaires pour effectuer des tâches à chacune des étapes de leurs projets, allant de la collecte à la visualisation des données.

Les logiciels propriétaires, tels que SPSS ou Microsoft Excel, sont souvent comparés à des boîtes noires où les données entrent et ressortent avec peu d’indications sur ce qui s’est passé à l’intérieur (Morin et al., 2012). Selon les conditions d’utilisation, l’inspection du code peut être interdite ou impossible. Les logiciels propriétaires sont souvent plus faciles à utiliser que les logiciels libres et ils sont parfois gratuits, parfois payants (Singh et al., 2015). Les logiciels libres sont souvent gratuits, mais ils peuvent être plus complexes à utiliser (Cox, 2019). Cette complexité est contrebalancée par la possibilité d’inspecter le code source et de modifier le programme lui-même selon ce qu’autorisent les licences des logiciels (Singh et al., 2015).

Un logiciel est un ensemble d’instructions textuelles qui exécute ou qui fonctionne avec l’aide d’un ordinateur. Les instructions sont assujetties à des règles articulées par le langage de programmation particulier dans lequel le logiciel a été écrit et l’exécution de ce code dépend de l’environnement informatique, qui regroupe des éléments tels que le matériel informatique et le système d’exploitation (Possati, 2020).

Le contrôle programmatique des versions de fichiers

Tel que discuté plus tôt dans le chapitre, la curation active des données implique beaucoup plus que la création d’une arborescence de dossiers et l’utilisation de pratiques uniformisées de nommage de fichiers. Vous devez également gérer le contenu des fichiers de façon systématique et avec transparence en gardant en tête leur réutilisation. Vous pouvez y arriver par le biais de la programmation en utilisant des fonctionnalités automatisées de gestion des versions disponibles dans de nombreux gestionnaires de documents infonuagiques tels que Office 365 et Google Docs. L’activité d’évaluation à la fin du chapitre est hébergée sur une plateforme de gestion des versions appelée GitHub qui est couramment utilisée par celles et ceux qui écrivent et développent du code.

La gestion des versions, ou versionnage implique le suivi des modifications apportées à un fichier, peu importe l’ampleur des modifications. Lorsque les fichiers sont sauvegardés par le contrôle automatique des versions, tant le contenu que les révisions sont automatiquement sauvegardés, permettant ainsi aux utilisateurs de revenir à toutes les sauvegardes antérieures du fichier (Vuorre et Curley, 2018). Dès que vous sauvegardez un fichier, chacune des modifications au fichier est enregistrée; le fichier est sauvegardé sous une nouvelle version sans avoir à lui attribuer un nouveau nom de fichier. Vous pourrez donc « revenir dans le temps » pour voir de quelle façon le fichier s’est développé puisque toutes ses modifications seront identifiées.

Des dépôts de données, tels que Dataverse et Zenodo, incluent des informations sur les versions dans les citations qu’ils génèrent, permettant ainsi à tout un chacun d’identifier laquelle des versions d’un jeu de données ou d’un manuscrit a été utilisée.

Le présent chapitre s’est surtout penché sur les projets dont les données sont créées par les chercheuses et chercheurs eux-mêmes. Pour les projets qui utilisent des données secondaires, il est essentiel d’accorder une attention particulière à la provenance. Arguillas et al. (2022) ont publié un excellent guide sur la curation et la reproductibilité qui comprend une discussion sur cet enjeu important.

La rédaction de scripts: pour rendre l’analyse reproductible et automatiser les processus de gestion des données

Automatiser les processus de travail de recherche, tels que l’importation, le nettoyage et la visualisation des données, vous permet de mettre en œuvre vos expériences computationnelles avec un minimum d’intervention manuelle. L’automatisation dépend des scripts, c’est-à-dire des ensembles de routines informatiques transcrites en code (Alston et Rick, 2021; Rokem et al., 2017). Les scripts devraient être accompagnés d’une documentation détaillée qui fait la description de chacune des étapes de la routine afin que la provenance d’une expérience puisse être comprise. La provenance en recherche computationnelle a la même signification que la provenance en archivistique; il s’agit d’un enregistrement de la source, de l’historique et de la propriété d’un artéfact. Dans le contexte présent, l’artéfact est de nature informatique.

L’automatisation et le suivi de la provenance facilitent la reproductibilité et la réutilisation pour les chercheuses et chercheurs et les évaluatrices et évaluateurs externes, mais les plus grands bénéficiaires seront toujours les membres de l’équipe de recherche originale (Rokem et al., 2017; Sawchuk et Khair, 2021). Une documentation détaillée permet d’identifier les erreurs et fournit de précieuses informations en matière de contexte pour la formation de nouveaux membres de l’équipe. L’automatisation permet de mener l’expérience à une ou plusieurs reprises avec un minimum d’effort, ce qui peut être particulièrement utile quand les jeux de données ont été modifiés ou mis à jour.

Dans certains cas, l’automatisation et la provenance peuvent avoir lieu au même endroit. Tel que déjà mentionné, les fichiers de syntaxe comprennent les commandes utilisées pour la manipulation, l’analyse et la visualisation des données; ces fichiers peuvent aussi être modifiés pour inclure des commentaires qui décrivent le raisonnement et l’analyse du projet. Les fichiers de syntaxe peuvent ensuite être regroupés avec les données et les fichiers de sortie, permettant à d’autres d’évaluer et de réutiliser le projet dans son ensemble.

Des cahiers électroniques de code sont d’autres outils qui intègrent l’automatisation et le suivi de la provenance à l’intérieur d’un seul document linéaire. Un cahier de codes, tel que Jupyter Notebook, est une interface qui encourage la pratique de la programmation lettrée, là où le code, les commentaires et les sorties s’affichent ensemble de façon linéaire, telle une œuvre de littérature (Hunt et Gagnon-Bartsch, 2021; Kery et al., 2018).

Une bonne documentation est essentielle pour la reproductibilité de la recherche, peu importe la personne qui réutilise les données (Benureau et Rougier, 2018). Une bonne pratique consiste à inclure des annotations descriptives avec toutes les ressources informatiques d’un projet afin de fournir un contexte précieux à toutes les étapes du cycle de vie de la recherche.

Le partage du code: les cahiers électroniques et les conteneurs informatiques

Le fonctionnement du code n’est pas garanti d’un ordinateur à l’autre. Des différences au niveau du matériel informatique, des systèmes d’exploitation, des logiciels installés et des privilèges administratifs créent des obstacles au fonctionnement ou à la lecture du code utilisé pour mener l’analyse des données. Des chercheuses ou chercheurs peuvent utiliser des formats de fichiers propriétaires qui ne sont accessibles qu’en achetant des logiciels particuliers ou en s’y abonnant. De plus, la littératie en matière de codage varie souvent chez les personnes qui mènent et gèrent les projets de recherche, entraînant des incohérences dans la documentation et l’inclusion d’erreurs (Hunt et Gagnon-Bartsh, 2021). Bien qu’il soit recommandé de partager les données de recherche et le code dans un dépôt qui facilite le versionnage, vous devriez également prendre des mesures concrètes au cours de la phase active d’un projet de recherche pour encourager la reproductibilité et la réutilisation.

Il existe plusieurs solutions techniques qui facilitent le partage du code et qui varient en complexité sur un spectre allant du statique au dynamique. L’approche statique pour le partage du code est simplement de téléverser le code brut vers un dépôt avec un fichier LISEZ-MOI bien documenté ainsi qu’une liste des dépendances ou des exigences au niveau de l’environnement informatique. Dans l’approche dynamique, les données, le code et les dépendances sont rassemblés dans un format autonome appelé un conteneur (Hunt et Gagnon-Bartsh, 2021; Vuorre et Crump, 2021).

Un conteneur informatique est comme un ordinateur autonome virtuel à l’intérieur d’un ordinateur. Les conteneurs peuvent être hébergés sur un service Web tel que Docker ou sur une clé USB. Ils comprennent tout ce qui est nécessaire pour faire fonctionner un logiciel (y compris le système d’exploitation), sans avoir à télécharger et installer des programmes ou des données. La mise en conteneur facilite la reproductibilité informatique, ce qui survient quand les aspects informatiques d’un projet de recherche peuvent être indépendamment reproduits par un tiers (Benureau et Rougier, 2018). Pour qu’un projet puisse être complètement reproductible, tous les produits de la recherche – en partant des données jusqu’au code et à l’analyse – doivent être inclus. Voilà pourquoi les conteneurs informatiques comprennent des informations détaillées sur l’environnement numérique utilisé pour mener la recherche (Hunt et Gagnon-Bartsch, 2021). Il s’agit notamment d’informations sur le type d’ordinateur et le système d’exploitation (p. ex., Mac OS Monterey v12.3, Windows v11, Linux Ubuntu v21.10); le nom et la version de tout logiciel commercial utilisé pour la collecte ou l’analyse des données; ou inversement, le langage de programmation utilisé pour créer le logiciel ainsi que le nom et le numéro de version de toute dépendance prise en charge par le logiciel.

Une dépendance est une bibliothèque de logiciels supplémentaires qui peut être téléchargée à partir d’Internet et utilisée pour certaines tâches précises de programmation. Par exemple, les personnes qui utilisent le langage de programmation Python peuvent aller en ligne et télécharger des ensembles complets de code déjà écrit pour certaines opérations spécifiques telles que la création de graphiques mathématiques ou l’analyse de texte. Les dépendances sont écrites et revues par des gens extérieurs au projet, ce qui signifie que les versions peuvent être mises à jour, soit régulièrement, soit pas du tout. Certaines dépendances sont plus largement utilisées et viennent avec beaucoup de documentation, tandis que d’autres ne le sont pas. Il est de la responsabilité de la chercheuse ou du chercheur de vérifier si le code fait bien ce qu’il doit faire et s’il n’y a pas d’erreurs ou de bogues qui pourraient avoir un impact sur les données ou sur les résultats d’analyse (Cox, 2019). Il est essentiel de bien documenter les dépendances (et leurs versions) d’un projet pour la recherche reproductible puisque même de petits changements entre les versions peuvent créer des ruptures dans le fonctionnement du code, ou pire, produire des résultats erronés.

Un des moyens les plus courants d’écrire du code pour des conteneurs informatiques est d’utiliser des cahiers de code électroniques. La mise en conteneur d’un cahier de code permet d’analyser et de modifier le code pour tester les sorties et les analyses. Les utilisatrices ou utilisateurs finaux peuvent faire des essais avec le code sans avoir à se soucier de causer des ruptures de fonctionnement ou des modifications permanentes. De plus, pas besoin de se soucier des questions de sécurité liées à l’installation des logiciels.

Conclusion

La curation active des données de recherche permet d’améliorer la recherche, car elle fait gagner du temps et réduit le potentiel d’erreurs. L’utilisation de processus de travail standardisés, l’application uniforme de méthodes d’organisation et d’étiquetage des produits de recherche et la création d’une documentation exhaustive facilitent la réutilisation, tant pour l’équipe de recherche primaire que pour des utilisatrices et utilisateurs secondaires. La normalisation améliore la découvrabilité des données dans les dépôts, ce qui permet l’ajout de jeux de données dans les revues systématiques et les méta-analyses augmentant ainsi la fréquence de citations et le profil de l’équipe de recherche.

Bien que les suggestions présentées dans ce chapitre soient considérées comme de meilleures pratiques, la meilleure gestion des données de recherche est de faire une gestion des données. Chacun des projets comportera ses défis particuliers, mais en veillant à la curation active des données, vous vous assurerez que la documentation est suffisante pour le dépôt et la découverte des données.

Questions de réflexion

Voir l’Annexe 3 pour une série d’exercices.

Éléments clés à retenir

- La curation active des données aide les chercheuses et chercheurs à s’assurer que leurs données sont précises, fiables et accessibles aux personnes qui en ont besoin. Quand les données de recherche sont gérées de façon appropriée et mises à jour, elles demeurent utiles et accessibles dans le temps.

- Les pratiques de gestion des données, telles que le versionnage et la rédaction de scripts, contribuent à améliorer l’exactitude et la sécurité des données. L’automatisation des descriptions, de l’organisation et du stockage des données de recherche permet de gagner du temps et limite les erreurs.

- Les outils qui favorisent la reproductibilité des calculs et de l’analyse – tels que les cahiers électroniques de laboratoire et les conteneurs informatiques – permettent aux recherches d’être reproduites et vérifiées. En ouvrant l’accès aux données et aux méthodes d’analyses, les chercheuses et chercheurs peuvent prouver la rigueur et la fiabilité de leur recherche ainsi que permettre à d’autres d’examiner leur travail.

Bibliographie

Alston, J. M. et Rick, J. A. (2021). A beginner’s guide to conducting reproducible research. The Bulletin of the Ecological Society of America, 102(2), 1–14. https://doi.org/10.1002/bes2.1801

Arguillas, F., Christian, T.-M., Gooch, M., Honeyman, T., Peer, L. et CURE-FAIR WG. (2022). 10 things for curating reproducible and FAIR research (1.1). Zenodo. https://doi.org/10.15497/RDA00074

Benureau, F. C. Y. et Rougier, N. P. (2018). Re-run, repeat, reproduce, reuse, replicate: Transforming code into scientific contributions. Frontiers in Neuroinformatics, 11. https://doi.org/10/ggb79t

Buchanan, E. M., Crain, S. E., Cunningham, A. L., Johnson, H., Stash, H. R., Papadatou-Pastou, M., Isager, P. I., Carlsson, R. et Aczel, B. (2021). Getting started creating data dictionaries: How to create a shareable data set. Advances in Methods and Practices in Psychological Science, 4(1), 1-10. https://doi.org/10.1177/2515245920928007

Cooper, A., Steeleworthy, M., Paquette-Bigras, È., Clary, E., MacPherson, E., Gillis, L. et Brodeur, J. (2021). Creating guidance for Canadian Dataverse curators: Portage Network’s Dataverse curation guide. Journal of EScience Librarianship, 10(3), 1-26. https://doi.org/10/gmgks4

Cox, R. (2019). Surviving software dependencies: Software reuse is finally here but comes with risks. ACMQueue, 17(2), 24-47. https://doi.org/10.1145/3329781.3344149

Groupe d’experts sur la formation. (2020, 2 septembre). Guide Éclair: Gestion des données de recherche. Zenodo. https://doi.org/10.5281/zenodo.4012530

Hunt, G. J. et Gagnon-Bartsch, J. A. (2021). A review of containerization for interactive and reproducible analysis. ArXiv. https://arxiv.org/abs/2103.16004

ICPSR Institute for Social Research. (2023). Glossary of social science terms. National Addiction and HIV Data Archive Program. https://www.icpsr.umich.edu/web/NAHDAP/cms/2042

Johnston, L., Carlson, J., Hudson-Vitale, C., Imker, H., Kozlowski, W., Olendorf, R. et Stewart, C. (2017a). Data Curation Network: A cross-institutional staffing model for curating research data. https://conservancy.umn.edu/bitstream/handle/11299/188654/DataCurationNetworkModelReport_July2017_V1.pdf

Johnston, L., Carlson, J. R., Kozlowski, W., Imker, H., Olendorf, R. et Hudson-Vitale, C. (2017b). Checklist of DCN CURATE steps. IASSIST & DCN – Data Curation Workshop 4. https://openscholarship.wustl.edu/data-curation-workshop-2017/schedule/Schedule/4

Kery, M. B., Radensky, M., Arya, M., John, B. E. et Myers, B. A. (2018). The story in the notebook: Exploratory data science using a literate programming tool. Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems, 1–11. https://doi.org/10.1145/3173574.3173748

Krier, L. et Strasser, C. A. (2014). Data management for libraries: A LITA guide. American Library Association.

Morin, A., Urban, J., Adams, P. D., Foster, I., Sali, A., Baker, D. et Sliz, P. (2012). Shining light into black boxes. Science, 336(6078), 159–160. https://doi.org/10/m5t

Possati, L. M. (2020). Towards a hermeneutic definition of software. Humanities and Social Sciences Communications, 7(1), 1–11. https://doi.org/10.1057/s41599-020-00565-0

Rokem, A., Marwick, B. et Staneva, V. (2017). Assessing reproducibility. Dans J. Kitzes, D. Turek et F. Deniz (dir.), The practice of reproducible research: Case studies and lessons from the data-intensive sciences. University of California Press. http://www.practicereproducibleresearch.org/core-chapters/2-assessment.html#

Sawchuk, S. L. et Khair, S. (2021). Computational reproducibility: A practical framework for data curators. Journal of EScience Librarianship, 10(3), 1-16. https://doi.org/10/gmgkth

Singh, A., Bansal, R. et Jha, N. (2015). Open source software vs proprietary software. International Journal of Computer Applications, 114(18), 26-31. https://doi.org/10/gh4jxn

Statistiques Canada. (1996). Manuel des codes A – Enquête nationale sur la santé de la population (ENSP) 1994-95 – Questions supplémentaires. https://www.statcan.gc.ca/fra/programmes-statistiques/document/3225_DLI_D2_T22_V1-fra.pdf

Vuorre, M. et Crump, M. J. C. (2021). Sharing and organizing research products as R packages. Behavior Research Methods, 53(2), 792–802. https://doi.org/10/gg9w4c

Vuorre, M. et Curley, J. P. (2018). Curating research assets: A tutorial on the Git Version Control System. Advances in Methods and Practices in Psychological Science, 1(2), 219–236. https://doi.org/10/gdj7ch

Wilkinson, M. D., Dumontier, M., Aalbersberg, Ij. J., Appleton, G., Axton, M., Baak, A., Blomberg, N., Boiten, J.-W., da Silva Santos, L. B., Bourne, P. E., Bouwman, J., Brookes, A. J., Clark, T., Crosas, M., Dillo, I., Dumon, O., Edmunds, S., Evelo, C. T., Finkers, R., Gonzalez-Beltran, A., … Mons, B. (2016). The FAIR Guiding Principles for scientific data management and stewardship. Scientific Data, 3. https://doi.org/10/bdd4

Capacité des données ou des outils provenant de ressources non coopératives à travailler ou à communiquer entre eux avec un minimum d'effort et en utilisant un langage commun. L'interopérabilité exige que les données et les métadonnées utilisent des formats normalisés, accessibles et largement utilisés. Par exemple, lors de la sauvegarde de données tabulaires, il est recommandé d'utiliser un fichier CSV plutôt qu'un fichier propriétaire tel que XLSX (Excel). Un fichier CSV peut être ouvert et lu par davantage de logiciels qu'un fichier XLSX.

Type d’outil en ligne basé sur la conception et l’utilisation des cahiers de laboratoire papier.

Lorsque du code ou un logiciel est ouvert ou en source libre, les personnes qui l’utilisent sont autorisées à inspecter, utiliser, modifier, améliorer et redistribuer le code sous-jacent. Plusieurs programmeuses et programmeurs utilisent la licence MIT lors de la publication de leur code, ce qui implique que toutes les itérations ultérieures du logiciel incluent également la licence MIT.

Terme qui décrit toutes les activités que les chercheuses et chercheurs effectuent pour structurer, organiser et préserver les données de recherche avant, pendant et après le processus de recherche.

Logiciel qui stocke les mots de passe. Certains gestionnaires de mots de passe peuvent aussi créer et suggérer des mots de passe plus complexes à utiliser.

Données qui ne peuvent être partagées sans risque de trahir la confiance ou de nuire à une personne, une entité ou une communauté.

Type d’authentification qui implique un mot de passe et un appareil. L’utilisation d’un mot de passe pour ouvrir une session dans un service entraîne une demande d’entrer un code à usage unique généré par un appareil tel qu’un cellulaire ou un ordinateur. Les codes à usage unique peuvent être transmis par message texte, par courriel ou ils peuvent être générés sur un appareil par le biais d’une application d’authentification telle que Google Authenticator. Plusieurs institutions bancaires et gouvernementales, telles que l’Agence du revenu du Canada, exigent maintenant l’activation de l’authentification multifactorielle.

Écriture sans espace ni ponctuation qui utilise des lettres majuscules afin de distinguer les mots.

Permet de garder une trace des modifications apportées à un fichier, aussi petites soient-elles. Également connue sous le nom de contrôle de version, cette opération s'effectue généralement à l'aide d'un système de contrôle de version automatisé tel que GitHub. De nombreux services de stockage de fichiers tels que Dropbox, OneDrive et Google Drive, conservent des versions historiques d'un fichier chaque fois qu'il est enregistré. Il est possible d'accéder à ces versions en consultant l'historique du fichier.

Fichier surtout utilisé par des sondeurs qui fournit des informations détaillées sur l'outil de sondage. Par exemple, on y retrouve les questions du sondage, les noms et définitions des variables utilisés pour coder les réponses du sondage, les valeurs acceptées pour chacune des variables, des statistiques sommaires pour chacune des questions, etc.

Fichier qui documente et décrit les différents éléments d'un jeu de données. Par exemple, il peut définir les variables, les unités de mesure utilisées, les valeurs acceptées pour les variables, etc. Le document est lisible et souvent exploitable par une machine, comme le guide de codification, et peut également contenir des informations détaillées sur la structure technique d’un jeu de données.

Texte inséré de façon automatique par un logiciel de sondage selon les réponses précédemment données par les personnes qui remplissent un questionnaire.

Recherche qui dépend des ordinateurs pour la création ou l’analyse des données.

Système qui fait automatiquement le suivi de chaque modification à un document ou fichier, permettant aux personnes qui l’utilisent de revenir à des versions sauvegardées antérieures sans avoir à continuellement enregistrer des copies sous différents noms.

Documentation faisant référence à la source, l’historique et la propriété d’un artéfact, que celui-ci soit analogique ou numérique.

Affichage de façon linéaire de code, commentaires et sorties, un peu comme une œuvre de littérature.

Caractère d’une recherche qui peut être reprise par des chercheuses ou chercheurs qui ne faisaient pas partie de l'équipe de recherche originale, mais qui utilisent les mêmes données pour arriver aux mêmes résultats.

Capacité de bien comprendre le code informatique, au même titre que la littératie en mathématiques (ou numératie) est la capacité de bien comprendre les mathématiques. L’apprentissage du code en informatique a souvent été comparé à l’apprentissage d’une nouvelle langue.

Document qui fournit des renseignements à propos d’un fichier ou d’un jeu de données. Il permet d’assurer la pérennité de l’interprétation correcte des données par toutes les personnes qui les consulteront.

Ordinateur autonome virtuel à l’intérieur d’un ordinateur. Il comprend tout ce qui est nécessaire pour faire fonctionner un logiciel (y compris le système d’exploitation), sans avoir à télécharger et installer des programmes ou des données.

Bibliothèque de logiciels supplémentaires qui peut être téléchargée à partir d’Internet et utilisée pour certaines tâches précises de programmation.